Was ist die Suchmaschinenindexierung und wie nehme ich meine Website aus der Indexierung heraus?

Was bedeutet „Suchmaschinenindexierung“

Damit Websites im Internet schneller gefunden werden und somit für die Öffentlichkeit zugänglich sind, werden diese durch ein automatisiertes Programm namens Spider, auch bekannt als Robot oder Crawler indexiert.

Die Spider „crawlen“ durch das Internet, besuchen die Seite und protokollieren die Inhalte.

Diese Ergebnisse werden dann von Google genutzt, um zu entscheiden, wie deine Websites in den Suchergebnissen platziert werden, indem Textpassagen aus deinen Artikeln für die Suchergebnisse übernommen werden.

Ebenfalls werden auch deine Bilder in Google Images eingepflegt.

Wird nun in WordPress der Haken bei „Suchmaschinen von der Indexierung abhalten“ gesetzt, ändert WordPress automatisch die robots.txt (eine Datei deiner Website mit Anweisungen für die Spider zum Crawlverhalten) deiner Website.

Ebenfalls kann die Option einen Meta-Tag in den Header deiner Website einfügen, wodurch Google und andere Suchmaschinen von der Indexierung der Inhalte deiner gesamten Website abgehalten werden.

Hier gibt es ein Schlüsselwort namens „entmutigen„

Suchmaschinen sind natürlich nicht verpflichtet, solch eine Aufforderung zu befolgen, insbesondere Suchmaschinen, welche nicht die Standard robots.txt verwenden wie z.B. Google.

In der Vergangenheit gab es bei dieser Option in WordPress einige Fehler, wodurch Google nicht davon abgehalten wurde, die Website in den Suchergebnissen anzuzeigen. Google wurde dadurch lediglich insofern blockiert, dass die Inhalte deiner Website nicht mehr Indexiert wurden.

Somit blieben die Websites weiterhin in den Suchergebnissen sichtbar, jedoch mit einem Fehler wie z.B. „Für diese Seite sind keine Informationen verfügbar“ oder auch „Eine Beschreibung für dieses Ergebnis ist aufgrund der robots.txt der Webseite nicht verfügbar.“.

Auch wenn Google die Seiten somit nicht indexiert hat, wurden sie jedoch trotzdem nicht komplett versteckt. Durch diesen Fehler war es für Personen möglich, Websites zu besuchen, welche sie eigentlich nicht sehen sollten.

Dieser Fehler und die darauf folgenden Probleme wurden jedoch mit WordPress 5.3 gelöst und funktionieren jetzt so wie sie sollen.

D.h. die Indexierung wird korrekt blockiert und die Auflistung der Website bei Google somit ebenfalls.

Warum sollte ich meine Website nicht indexieren?

Im Normalfall sind Websites dazu gemacht, von Menschen gesehen zu werden. Es gibt jedoch auch ein paar Gründe, wieso ein Teil oder die gesamte Website ausgeblendet werden soll:

- Die Website befindet sich noch in der Entwicklungsumgebung oder ist noch nicht fertig gestellt

- Die Inhalte der Website sollen privat bleiben

- Du willst eine Paywall oder andere Beschränkung für exklusive Inhalte verwenden

- Du möchtest sensible Informationen verstecken

- Die Website soll nur für eine kleine Anzahl von Leuten oder per Link/Einladung bereitgestellt oder zugänglich sein, jedoch nicht für öffentliche Suchdienste

- Du willst SEO Abstrafungen für Testseiten oder kopierten Content verhindern

- Du willst den Traffic zu alten, veralteten Artikeln beschränken

Für einige dieser genannten Gründe gibt es jedoch deutlich bessere Lösungen. Diese sind z.B. das erstellen von privaten Artikeln in WordPress oder die Verwendung eines Offline-Entwicklungsservers.

Ebenfalls gibt es auch einen Passwortschutz, welcher vorgeschaltet werden kann.

Wie prüfe ich den Indexierungsstatus?

Auch wenn es sehr viele Gründe dafür gibt, eine Website nicht zu indexieren, kann dies natürlich eine fatale Auswirkung haben, wenn die Einstellung unbeabsichtigt aktiviert wurde oder ungewollt noch aktiv ist. Sollte also kein Traffic über deine Website laufen, wäre dies der erste Punkt, welcher kontrolliert werden sollte.

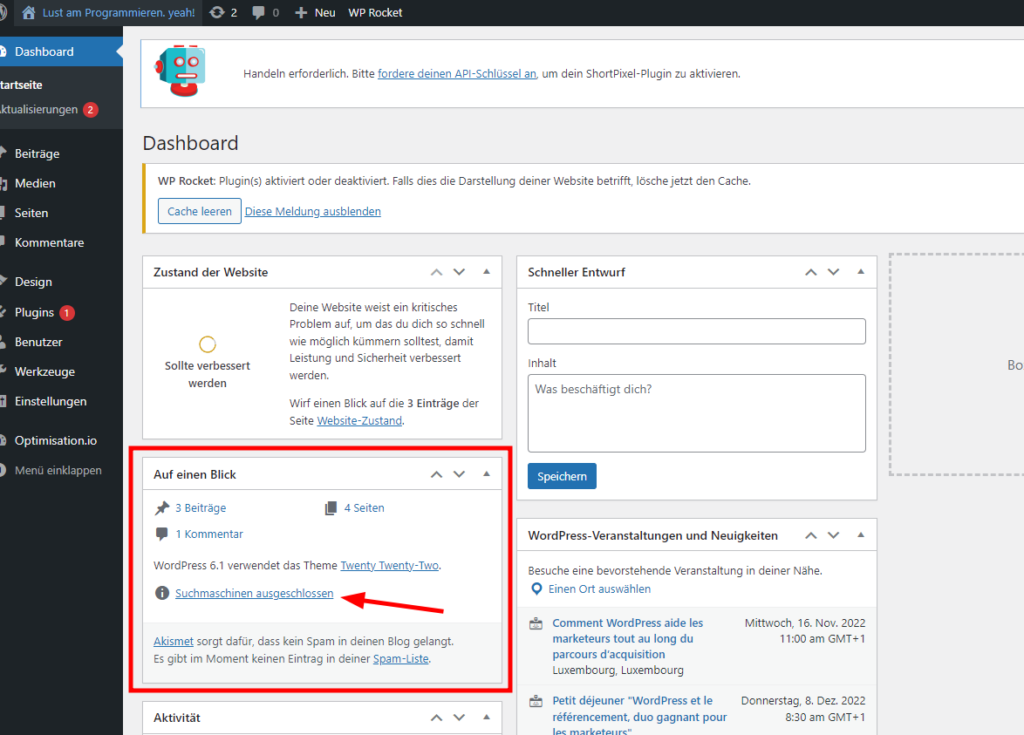

Zum kontrollieren, ob die Website indexiert wird oder nicht, eignet sich die „At a Glance“ (Auf einen Blick) Box auf dem Startbildschirm deines WordPress-Dashboards. Solltest du hier „Search Engines Discouraged“ sehen, weißt du, dass die Einstellung aktiviert ist.

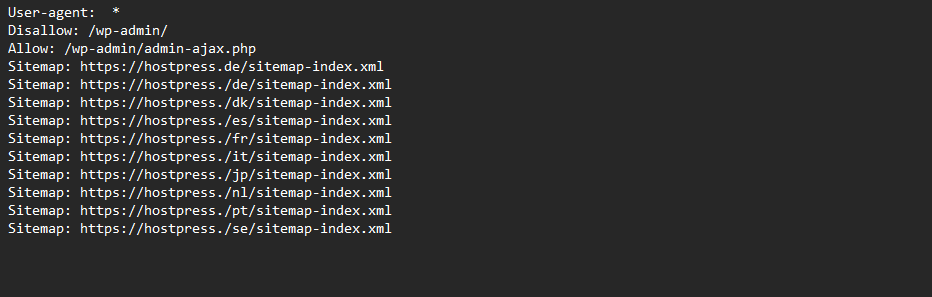

Noch zuverlässiger ist es natürlich, die robots.txt direkt zu prüfen. Dies kannst du einfach über den Browser erledigen, ohne dich auf deiner Website einloggen zu müssen.

Damit du die robots.txt aufrufen und überprüfen kannst, musst du lediglich /robots.txt an das Ende der URL deiner Website anhängen. Bei unserem Beispiel ist dies: https://www.hostpress.de/robots.txt.

Solltest du hier irgendwo disallow: / sehen, wird deine Website komplett von der Indexierung ausgeschlossen.

Siehst du allerdings Disallow: gefolgt von einem URL-Pfad, wie z.B. Disallow: /wp-admin/ bedeutet dies, dass alle URL´s deiner Website mit dem Pfad /wp-admin/ für die Indexierung blockiert werden.

Dies sollte normalerweise für jede Seite so sein. Wird hier jedoch ein anderer Pfad wie z.B. /blog/ angegeben, werden hier alle Seiten mit /blog/ blockiert und nicht indexiert.

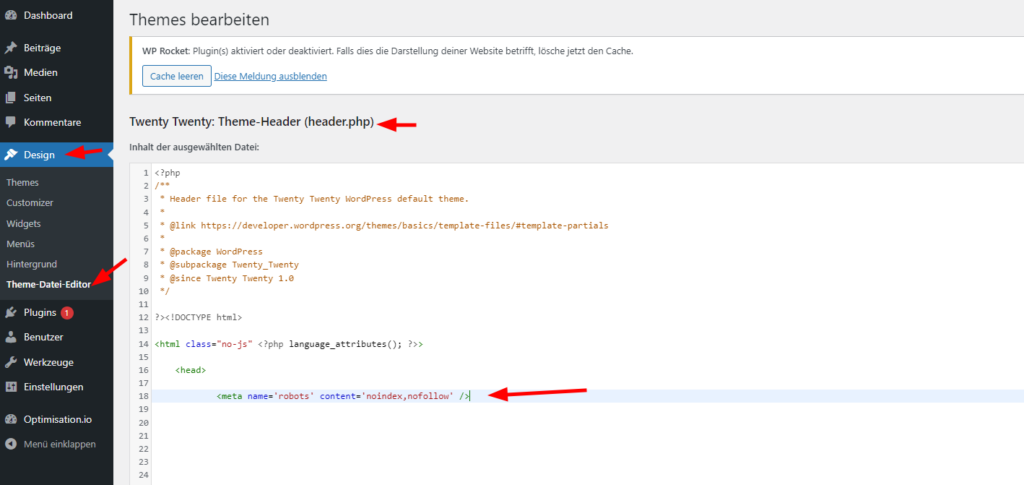

Da die aktuellen WordPress Versionen mittlerweile Meta-Tags anstatt der robots.txt zur Deindexierung der Websites verwenden, solltest du hier auch den Header auf Änderungen überprüfen.

Hierzu loggst du dich in dein Backend ein und gehst zu Design- Theme Editor. Dort solltest du nun deinen Theme Header (header.php) finden und suchst in diesem nach folgendem Code:

<meta name='robots' content='noindex,nofollow' />

Man kann auch in der functions.php nach dem noindex-Tag suchen, da auch hier eine Blockierung vorliegen kann.

Solltest du diesen Code in deinen Theme-Dateien finden, wird deine Website nicht von Google indexiert.

Bevor du hier jedoch versuchst, dies manuell zu entfernen, solltest du versuchen, die ursprüngliche Einstellungen zu deaktivieren.

Wie verhindere ich die Suchmaschinenindexierung?

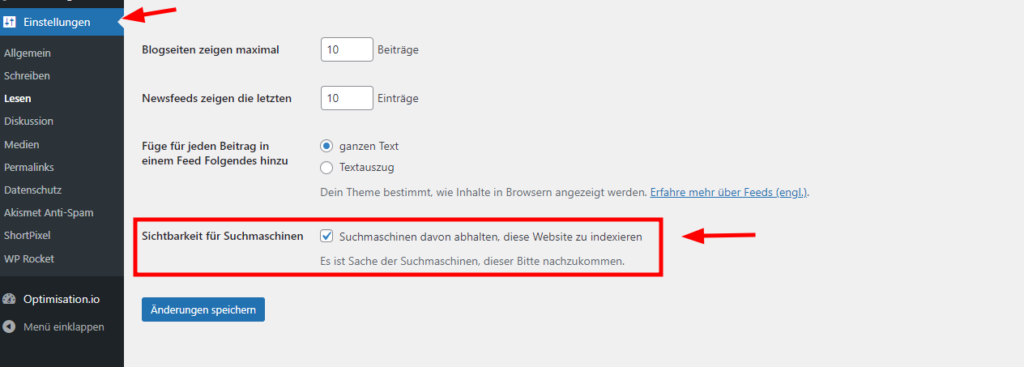

Die Suchmaschinenindexierung lässt sich relativ einfach über das WordPress Backend selbst aktivieren oder deaktivieren.

Dazu loggt man sich im WordPress Dashboard ein und navigiert zu Einstellungen – Lesen:

Hier findet man den Punkt „Suchmaschinensichtbarkeit“ mit einem Kontrollkästchen „Suchmaschinen davon abhalten, diese Webseite zu indexieren„.

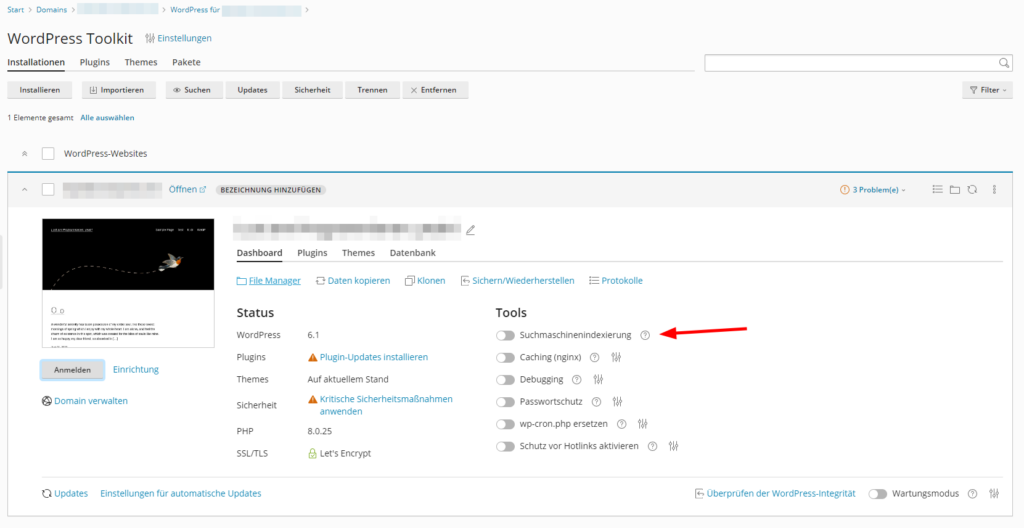

Ebenfalls kannst du dies direkt über das WordPress Toolkit aktivieren oder deaktivieren.

Solltest du feststellen, dass diese Option bereits aktiv ist, du jedoch möchtest, dass deinen Website indexiert werden soll, musst du diese Option deaktivieren.

Möchtest du jedoch verhindern, dass die Website indexiert wird, musst du diese Option aktivieren.

Durch einen klick auf „Änderungen speichern“ wird die Änderung aktiv. Es kann jedoch einige Zeit dauern, bis die Website neu indexiert wird oder aus dem Index verschwindet.

Sollte deine Website jedoch noch immer deindexiert sein, nachdem du die oben genannte Einstellungen geändert hast, kannst du auch den noindex – Code aus deiner Header-Datei entfernen und ebenfalls die robots.txt manuell bearbeiten, damit der „Disallow„-Flag entfernt wird.

Nachteile der Discourage Search Engines Option

Wie du siehst, ist es relativ einfach, die Indexierung zu aktivieren oder zu deaktivieren.

Allerdings solltest du dich hier nicht auf eine Einstellung alleine verlassen, denn alles was diese Einstellung macht, ist ein Tag in dem Header oder der robots.txt zu setzen.

Trotzdem kann dies manchmal nicht genügen, dass deine Websites wirklich versteckt sind.

Darüber hinaus liegt es ganz in der Hand der Suchmaschine, der Aufforderung nachzukommen, deine Website nicht zu crawlen.

Große Suchmaschinen wie Google oder Bing werden dies auch in der Regel tun, jedoch verwenden nicht alle Suchmaschinen die gleichen robots.txt- Syntax und auch nicht alle Spider, die im Internet crawlen, werden von Suchmaschinen ausgesandt.

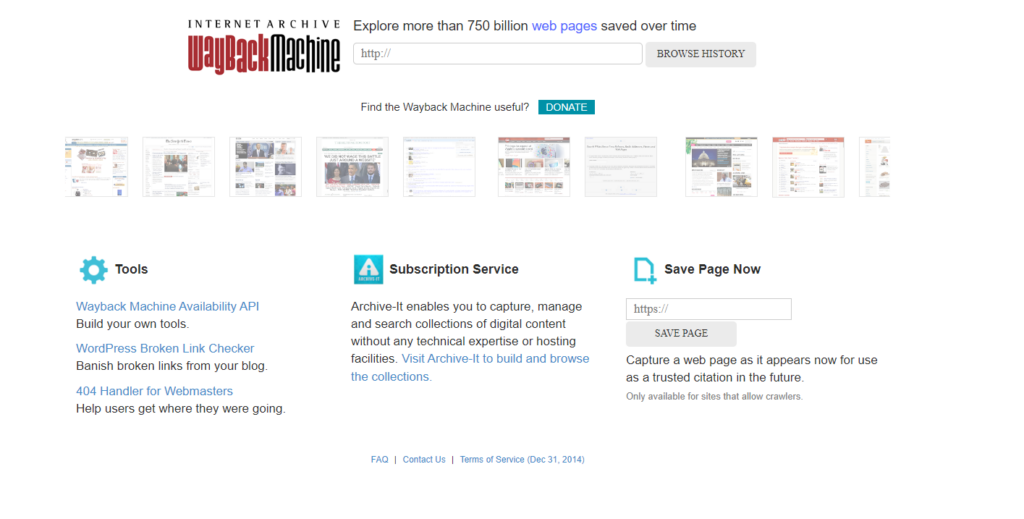

Als Beispiel für einen Dienst, welcher Webcrawler verwendet, nehmen wir hier Wayback Machine.

Wird deine Website von einem solchen Dienst gecrawlt, ist diese für immer im Web.

Solltest du also Inhalte auf deiner Website haben, die du deindexieren willst, da diese sensibel oder persönlich sind, solltest du dich auf keinen Fall auf robots.txt oder einen Meta-Tag verlassen.

Oft passiert es dadurch nämlich, dass die komplette Website vor den Suchmaschinenversteckt wird, anstatt wie gewollt nur bestimmte Seiten.

Welche anderen Möglichkeiten gibt es?

Für den normalen Zweck sind die durch WordPress bereitgestellten Optionen wohl ausreichend.

In manchen Situationen gibt es allerdings bessere Methoden zum verbergen von Inhalten.

Hier wird sogar von Google selbst gesagt, dass man hierfür nicht die robots.txt verwenden sollte.

Solange deine Website also auf einem öffentlichen Server läuft und einen Domainnamen hat, gibt es keine Möglichkeit zu garantieren, dass die Inhalte nicht von Crawlern gesehen oder indexiert werden.

Dies würde nur funktionieren, wenn du die Inhalte löschst oder hinter einem Passwort bzw. einer Login-Aufforderung versteckst.

Hier gehen wir auf einige Möglichkeiten ein, mit welchen du trotzdem deine Website oder bestimmte Seiten verbergen kannst.

Suchmaschinen über die .htaccess blockieren

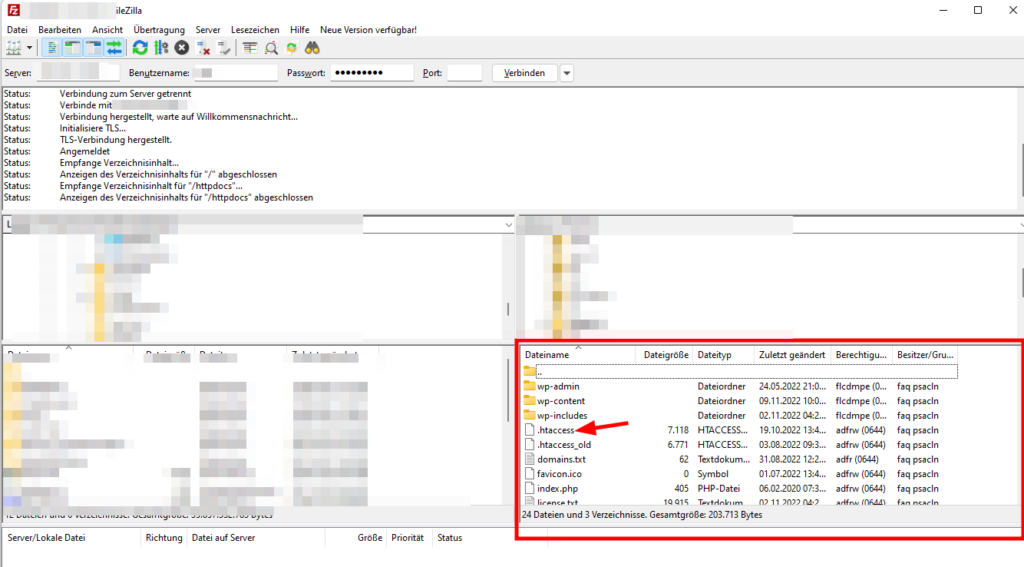

Auch wenn diese Lösung in etwa die gleiche ist wie die Option „Suchmaschinen abhalten„, kannst du auch manuell über die .htaccess-Datei die Indexierung der Website blockieren.

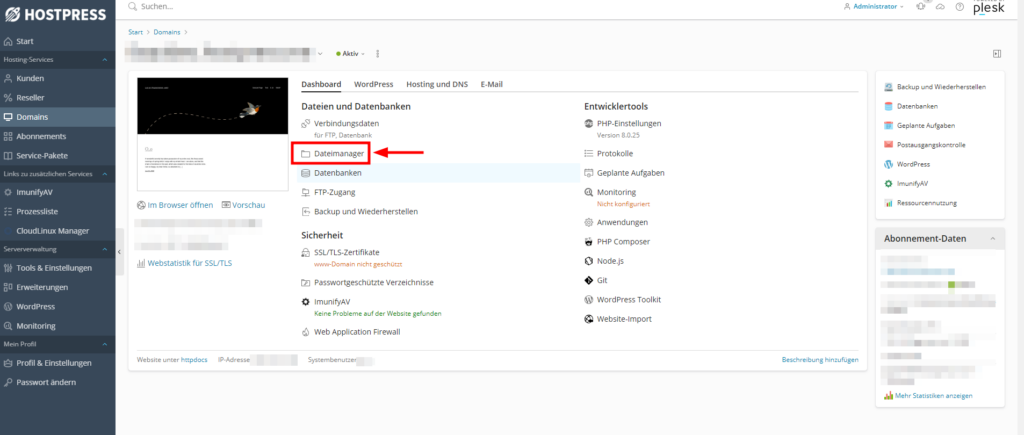

Hierzu kannst du entweder einen FTP Client oder einen Dateimanager verwenden.

In unserem Fall gibt es einen Dateimanager in Plesk selbst.

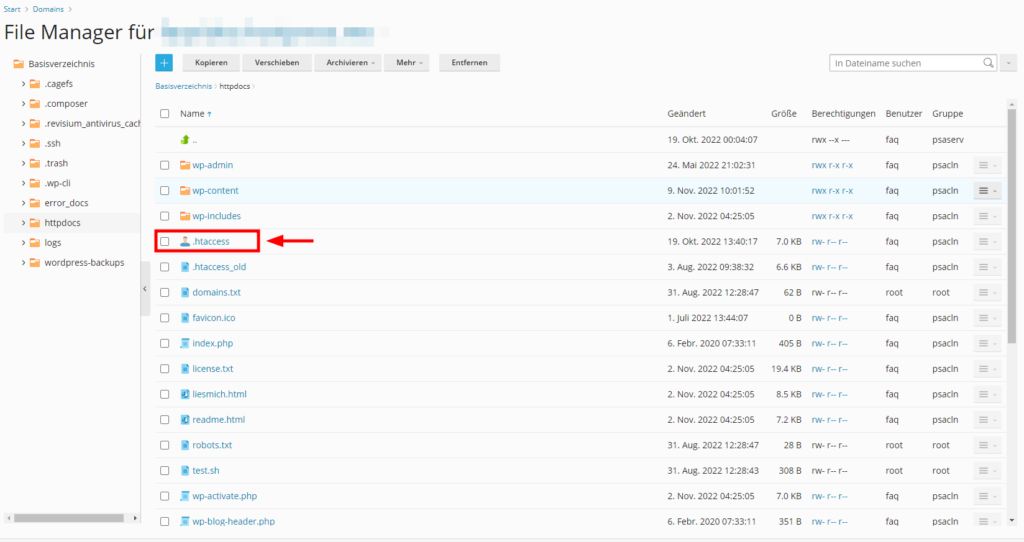

Die .htaccess-Datei findest du im Root-Order bzw. Basisverzeichnis (bei uns httpdocs) deiner Website.

In diese muss nun folgender Code eingefügt werden:

Header set X-Robots-Tag "noindex, nofollow"

Wichtig: Diese Methode funktioniert nur auf Apache-Server, nicht bei Nginx Server. Bei NGINX-Server muss dies in die .conf-Datei eingefügt werden. Diese befindet sich unter /etc/nginx/

add_header X-Robots-Tag "noindex, nofollow";Webseiten per Passwort schützen

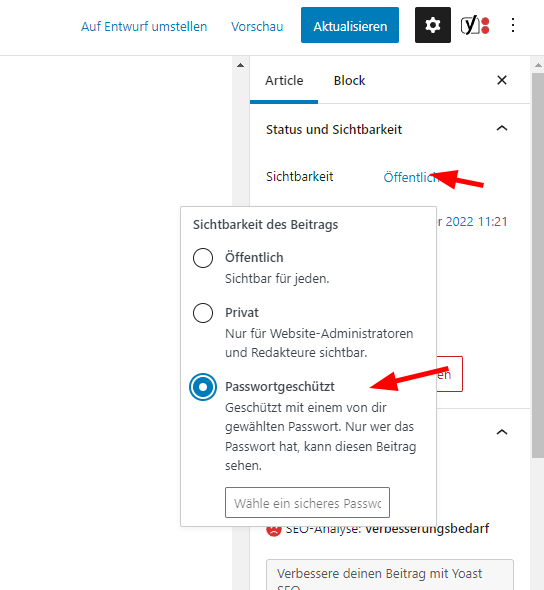

Enthält deine Website bestimmte Artikel oder Seite, wo du nicht möchtest, dass diese von Suchmaschinen indexiert werden, kannst du diese über ein Passwort schützen.

Somit können diese nur von dir und ausgewählten Nutzern gesehen werden

Diese Funktion kannst du ohne Plugin oder sonstiges verwenden, da dies bereits in WordPress selbst implementiert ist.

Gehe dazu einfach auf die Seiten-Beiträge und klicke auf die Seite, welche du ausblenden bzw. per Passwort schützen willst. Bearbeite diese Seite und suche dann auf der rechten Seite nach dem Menü Status und Sichtbarkeit – Sichtbarkeit.

Verwendest du hier einen anderen Builder als Gutenberg, ist der Prozess ähnlich.

Das gleiche Menü findest du in der Publish-Box.

Ändere hier nun die Sichbarkeit auf „Passwortgeschützt“ und gib ein Passwort ein.

Danach speicherst du das ganze noch ab und hast den Inhalt nun vor der Allgemeinheit verborgen.

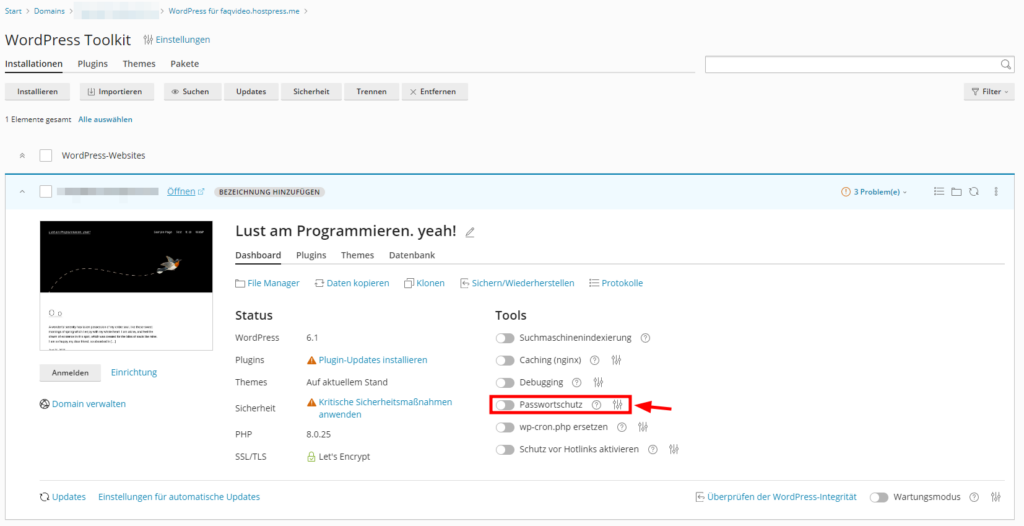

Möchtest du die gesamte Website mit einem Passwort schützen?

Dies kannst du direkt über das WordPress Toolkit erledigen.

Erweitere Lösung über ein Plugin

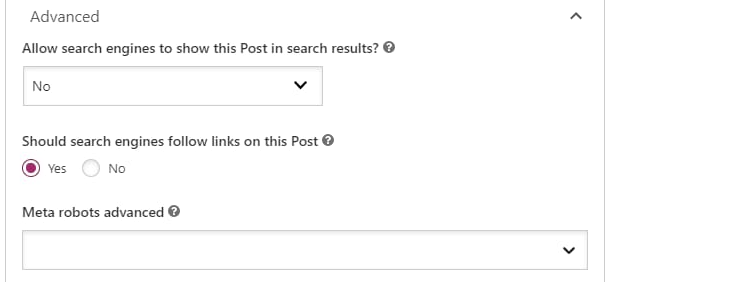

Reichen dir die Standardfunktionen von WordPress hierzu nicht aus, kann ein gutes Plugin oft die Lösung des Problems sein.

Hier empfehlen wir Yoast SEO. In Yoast SEO kannst du z.B. eine Seite, welche du ausblenden möchtest, öffnen und in dem Reiter „Erweitert“ nach folgender Option suchen:

„Erlaube Suchmaschinen, diesen Beitrag in den Sucherergebnissen anzuzeigen?“

Dies setzen wir nun auf „Nein“ und die Seite wird versteckt.

Hier sollte beachtet werden, dass beide Methoden auf die Standardoption von WordPress zurückgreifen, um die Indexierung zu verhindern.

D.h. sie unterliegen auch den gleichen Fehlern. Es kann noch immer vorkommen, dass einige Suchmaschinen die Anfrage nicht erkennen. Hier müssen andere Methoden angewandt werden, solltest du den Inhalt komplett verstecken wollen.

Eine andere Lösung dafür wäre eine sog. „Paywall“ oder ein erforderlicher Login.

Hier eignen sich die Plugins Simple Membership oder Ultimate Member dafür, um unterschiedliche Inhalte kostenlos oder kostenpflichtig einzurichten.

Dauerhafte Entfernung aus der Indexierung

Für die dauerhafte Entfernung aus dem Index bietet es sich an, die gewünschte Seite auf dem Webserver zu löschen. Sollte dies gemacht worden sein, wird nun ein Statuscode 404 (nicht gefunden) oder 410 (gelöscht) beim Aufruf der Seite zurückgegeben.

Auch bei Google direkt sollte die Löschung beantragt werden.

https://support.google.com/webmasters/answer/9689846?hl=de

Direkte Tools der Suchmaschinen

Fast jede Suchmaschine hat auch eigene und einige Tools zum entfernen von Seiten aus dem Suchindex.

Dies ist allerdings immer nur temporär bis zum nächsten Crawling-Vorgang.

Ist die Seite somit weiterhin online, wird diese erneut durch den Crawler indexiert.

Hier findest du einige Beispiele für die Tools der einzelnen Suchmaschine:

Tools und Infos zum entfernen aus dem Google-Index

Tools und Infos zum entfernen aus dem Yahoo-Index

Tools und Infos zum entfernen aus dem Index von Bing

Vorübergehende Sperrung über die Google Search Console

Bei der Google Search Console handelt es sich um einen Dienst, welcher es dir ermöglicht, die Eigentumsrechte an deiner Website zu beanspruchen.

Dadurch hast du die Möglichkeit, Google vorübergehend von der Indexierung bestimmter Seiten abzuhalten.

Allerdings gibt es hier auch ein paar Probleme:

Da es sich dabei um ein Google-Exklusive-Tool handelt, hat dieses somit keinen Einfluss auf andere Suchmaschinen wie z.B. Bing. Ebenfalls hält die Indexierungssperre nur 6 Monate an.

Suchst du jedoch einen schnellen und einfachen Weg, um deine Inhalte vorübergehend aus den Google-Suchergebnissen zu entfernen, ist dies die Lösung.

Für die Umsetzung dieser Lösung fügst du einfach deine Website der Google Search Console hinzu, sofern du dies noch nicht getan hast.

Danach öffnest du in der Google Search Console die Entfernungen und wählst dort „Temporäre Entfernungen – neue Anfrage„.

Nun klickst du auf „Nur diese URL entfernen“ und verlinkst die Seite, welche ausgeblendet werden soll.

Dieser Weg ist noch zuverlässiger, um Inhalte zu sperren, hält allerdings aber ebenfalls nur 6 Monate wie oben erwähnt und ist Google Exclusive.